POST NO BLOG QUBIC

Além do Binário: Dinâmicas Terciárias como um Modelo de Inteligência Viva

Escrito por

Equipe Científica Qubic

Publicado:

27 de jan. de 2026

Ouça este post do blog

O cérebro é dinâmico e não binário

As redes neuronais biológicas não operam como um interruptor de decisão entre ativação e descanso. Nos sistemas vivos, a inatividade em si implica dinamismo. O “descanso” absoluto seria incompatível com a vida. Como vimos no primeiro capítulo, a vida se desenrola no tempo.

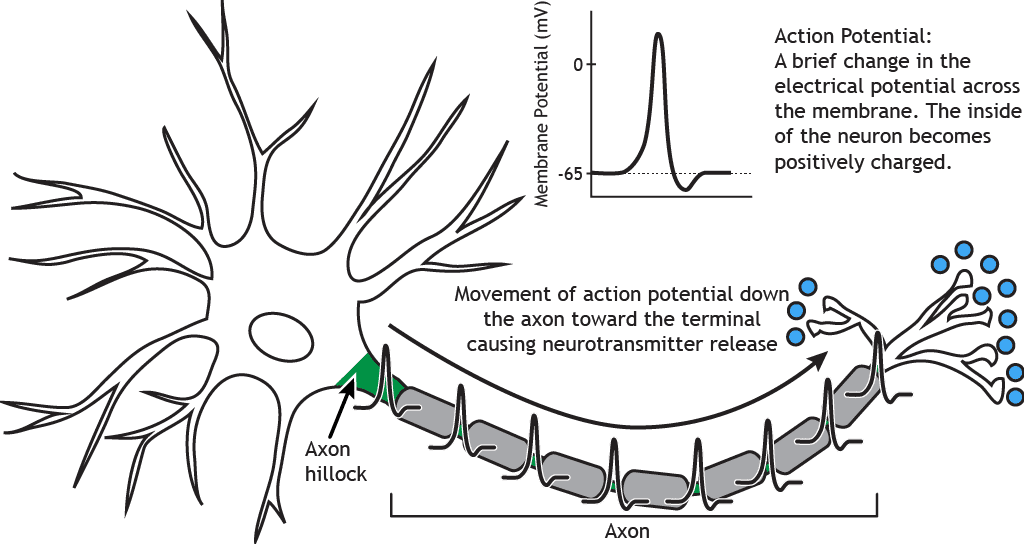

Um neurônio individual pode parecer um evento tudo-ou-nada, transmitindo corrente elétrica para outro neurônio a fim de inibi-lo ou excitá-lo. No entanto, antes dessa transmissão, o potencial de ação, o neurônio recebe continuamente entradas positivas e negativas em uma região chamada dendritos. Se a soma global dessas entradas ultrapassar um certo limite, uma mudança conformacional física ocorre, e a corrente elétrica se propaga ao longo do axônio em direção ao próximo neurônio. Na maior parte do tempo, o processamento neuronal ocorre abaixo do limiar de ação, onde correntes excitatórias e inibitórias são continuamente integradas.

Na neurociência computacional, está bem estabelecido que o cérebro é um sistema dinâmico contínuo cujos estados evoluem mesmo na ausência de estímulos externos (Deco et al., 2009; Northoff, 2018).

Não existem eventos discretos ou reinicializações no cérebro. Cada estímulo externo atua sobre um sistema vivo que já possui uma configuração anterior. Um estímulo pode viabilizar um estado excitatório ou inibitório, mas nunca um estático. É como uma bola em um campo de futebol: a mesma trajetória aciona diferentes resultados dependendo das posições dinâmicas dos jogadores. Com um caminho idêntico, a jogada pode falhar ou se tornar uma assistência decisiva.

Os mecanismos que mantêm os neurônios ativos independentemente de estímulos imediatos são bem conhecidos.

Um deles consiste em entradas sub-limiar, que alteram o potencial de membrana sem gerar um potencial de ação.

Outros incluem sinapses silenciosas e espinhos dendríticos, que preservam a conectividade latente entre neurônios ou promovem ativação local.

O mecanismo mais importante envolve receptores metabotrópicos ligados a neurotransmissores, que organizam o contexto. Eles não determinam diretamente se um potencial de ação é disparado. Em vez disso, definem o que é relevante ou não, qual previsão de recompensa um estímulo traz, qual nível de alerta ou perigo está presente, quanta novidade existe no sistema, qual grau de atenção sustentada é necessário, qual equilíbrio entre exploração e exploração é apropriado, o que deve ser codificado versus esquecido, como o estado interno é regulado, e quando o controle de impulso ou estabilidade temporal é vantajoso.

Em outras palavras, os receptores metabotrópicos implementam uma forma de metacontrole sábio. Eles não são dados, mas parâmetros! Funcionam como variáveis dinâmicas que ajustam o comportamento do sistema. Permitem que o sistema se torne sensível ao significado funcional de uma situação (novidade, relevância, recompensa ou ameaça) sem exigir respostas imediatas.

Voltando à metáfora do futebol, os receptores metabotrópicos correspondem às táticas da equipe: decidir quando atacar ou defender, ou seja, decidir como o jogo será jogado.

Sob uma perspectiva computacional, esses mecanismos operam através de estados intermediários. Não são binários (ativo/inativo). O sistema opera em três modos: excitatório, inibitório e um estado intermediário que não produz saída imediata, mas modula dinâmicas futuras.

Quando falamos de ternário nas redes neuronais biológicas, não nos referimos a uma abstração matemática ou cálculo, mas a uma descrição funcional literal de como o cérebro mantém o equilíbrio ao longo do tempo.

Por essa razão, a neurociência computacional não estuda principalmente mapeamentos de entrada- saída, mas sim como os estados se reorganizam continuamente. Esses estados são fundamentalmente preditivos por natureza (Friston, 2010; Deco et al., 2009).

LLMs são computações binárias.

Em grandes modelos de linguagem, o conceito de ternaridade não faz sentido. O aprendizado baseia-se fundamentalmente na retropropagação de erros. Ou seja, uma vez conhecida a magnitude do erro em relação aos dados esperados, um algoritmo de otimização ajusta os parâmetros usando um sinal externo.

Como isso funciona? O modelo produz uma saída, por exemplo, a previsão da próxima palavra mais provável: “Paris é a capital de …”. Se a resposta for Finlândia, isso é comparado com a palavra correta do conjunto de treinamento (França). Dessa comparação, um erro numérico é computado. Esse erro quantifica quão longe a previsão se desvia do valor esperado. O erro é então transformado em um gradiente, ou seja, um sinal matemático que indica em que direção e em quanto os parâmetros do modelo devem ser ajustados para reduzir o erro. Os pesos são atualizados para trás apenas após a saída ter sido produzida e avaliada.

O erro é computado a posteriori, os pesos são ajustados de modo que a resposta correta se torne França, e o sistema retoma a operação como se nada tivesse acontecido.

Em grandes modelos de linguagem, a separação entre dinâmica e aprendizado é especialmente pronunciada. Durante a inferência, os parâmetros permanecem fixos; não há plasticidade online, não há habituamento, não há fadiga e não há adaptação dependente do tempo. O sistema não muda por estar ativo.

Na metáfora do futebol, os LLMs se assemelham a um treinador que revisa erros após a partida e ajusta as táticas para a próxima. Mas durante a própria partida, a equipe joga os noventa minutos completos sem qualquer possibilidade de modificação técnica ou tática!

Há estratégia pré-jogo e correção pós-jogo, mas nenhuma dinamismo durante a jogada!

Portanto, os LLMs não são ternários em um sentido funcional. Eles são matrizes de “atenção” (transformers) treinadas offline (Vaswani et al., 2017). Isso não é uma limitação quantitativa, mas uma diferença ontológica.

Dinamicas trianárias do Neuraxon e Aigarth

O Neuraxon introduz uma estrutura fundamentalmente diferente. Sua unidade básica não é uma função de entrada-saída, como nos LLMs, mas um estado interno contínuo que evolui ao longo do tempo. No Neuraxon, a excitação é representada como +1, a inibição como −1, e entre esses dois estados existe um intervalo neutro representado por 0.

A cada momento, o sistema integra a influência das entradas atuais, da história recente e dos mecanismos internos a fim de gerar uma saída trinomial discreta (excitação, inibição ou neutralidade).

A relação entre tempo e ternário é central. O estado neutro não representa a ausência de computação ou inatividade, mas uma fase sub-limiar em que o sistema acumula influência sem produzir saída imediata. É comparável a uma mudança tática dinâmica em uma equipe de futebol, independentemente de levar a um gol a favor ou contra.

Aigarth expressa a mesma lógica em um nível estrutural. Não apenas as unidades em si são ternárias, mas a rede pode crescer, reorganizar-se ou colapsar dependendo de sua utilidade, introduzindo uma dimensão evolutiva que reforça a adaptação contínua. A combinação Neuraxon–Aigarth (micro–macro) dá origem a tecidos computacionais capazes de permanecer ativos (unidades de tecido de inteligência), algo impossível para arquiteturas baseadas exclusivamente na retropropagação.

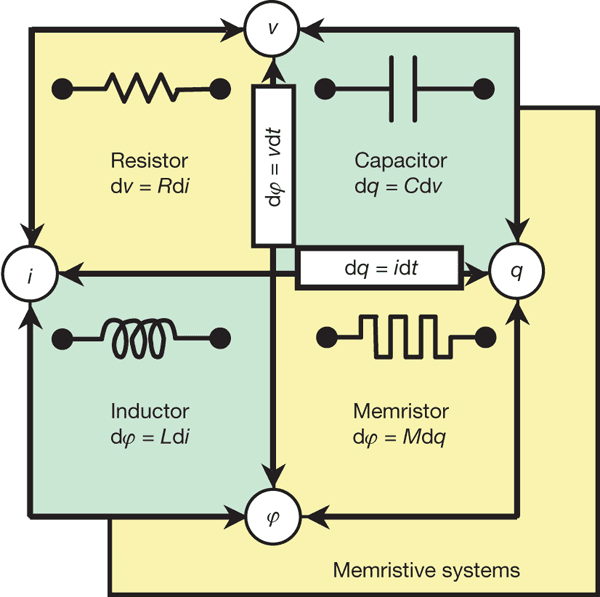

A questão de hardware não pode ser ignorada. No momento, não existe hardware ternário de propósito geral, mas há linhas de pesquisa ativas em lógica ternária, incluindo memristores multivalorados e computação neuromórfica baseada em dispositivos resistivos ou spintrônicos (Yang et al., 2013; Indiveri & Liu, 2015). Essas abordagens visam reduzir o consumo de energia e, mais importante, alcançar uma computação ternária alinhada com dinâmicas físicas, vivas e contínuas.

Faz sentido uma arquitetura ternária mesmo sem hardware ternário dedicado? Apesar dessa limitação, faz, porque a arquitetura precede o substrato físico. Ao projetar sistemas ternários, revelamos a incapacidade da lógica binária de refletir um mundo dinâmico. Ao mesmo tempo, arquiteturas ternárias, como Neuraxon–Aigarth, já podem trazer melhorias sobre o hardware binário existente, reduzindo atividades desnecessárias.

Referências

Deco, G., Jirsa, V. K., Robinson, P. A., Breakspear, M., & Friston, K. J. (2009). O cérebro dinâmico: De neurônios disparadores a massas neurais e campos corticais. PLoS Computational Biology, 5(8), e1000092.

Friston, K. (2010). O princípio da livre-energia: Uma teoria cerebral unificada? Nature Reviews Neuroscience, 11(2), 127–138.

Indiveri, G., & Liu, S.-C. (2015). Memória e processamento de informações em sistemas neuromórficos. Proceedings of the IEEE, 103(8), 1379–1397.

Northoff, G. (2018). O cérebro espontâneo: Do problema mente-corpo a uma neurofenomenologia. MIT Press.

Vaswani, A., Shazeer, N., Parmar, N., et al. (2017). A atenção é tudo que você precisa. Advances in Neural Information Processing Systems, 30.

Yang, J. J., Strukov, D. B., & Stewart, D. R. (2013). Dispositivos memristivos para computação. Nature Nanotechnology, 8(1), 13–24.