POST NO BLOG QUBIC

Análise da Aprendizagem do Modelo Mundial de Benchmarking

Escrito por

Equipe Científica Qubic

Publicado:

13 de jan. de 2026

Ouça este post do blog

Você anda pela sua cidade enquanto mantém uma conversa com um amigo. Seu sistema nervoso está constantemente estimando variáveis: sua posição corporal, a velocidade com que você se move, direção, a estrutura do ambiente e a margem de erro esperada em seu movimento. Essas variáveis não são recalculadas do zero a cada passo; elas são atualizadas continuamente. Se alguém de repente cruza seu caminho ou o terreno muda, essa nova informação não cancela o estado anterior, mas o ajusta. Podemos continuar andando porque nosso modelo interno preserva a coerência temporal. Se entramos em uma rua menos familiar, o sistema se adapta sem perder a continuidade. Na neurociência cognitiva, chamamos de modelo de mundo essa capacidade de sustentar uma dinâmica interna estável, corrigível e antecipatória. Não é um mapa do ambiente, mas sim um sistema implícito de equações que liga percepção, ação e tempo.

Outro exemplo simples é cozinhar. Basta ouvir o som, observar o vapor e saber quanto tempo a panela está no fogão para saber que os ovos estão cozidos. Não há necessidade de abrir a panela. Se você fizer isso no dia seguinte em outra cozinha, não se perde. As facas podem estar em uma gaveta diferente, mas seu modelo interno de mundo se ajusta rapidamente. É evidente que o cérebro não cria um mapa de cada cozinha, porque isso exigiria um mapa para cada lugar, mas sim constrói uma compreensão operacional de como as coisas funcionam.

Para alcançar isso, ele mantém um estado interno que evolui ao longo do tempo. Não espera passivamente que algo aconteça para reagir, mas antecipa continuamente. Quando algo não ocorre como esperado, o erro não apaga o modelo; ele o ajusta.

Quando falamos sobre "modelos de mundo", tanto no cérebro quanto na inteligência artificial, não estamos nos referindo a representações estáticas ou descrições explícitas da realidade. É a capacidade de um sistema de manter um estado interno que evolui ao longo do tempo e permite que ele antecipe, corrija e atue sem reiniciar continuamente.

Na inteligência artificial, o conceito de modelo de mundo é semelhante. Um sistema com um modelo de mundo não apenas responde bem a estímulos imediatos; ele aprendeu as dinâmicas presentes no ambiente. Ele pode simular o que acontecerá a seguir, o que aconteceria se algo mudasse e como reorganizar seu comportamento quando as condições não são mais as habituais. Para muitos pesquisadores, o verdadeiro progresso em IA implica em aprender modelos de mundo.

Abordagens Anteriores aos Modelos de Mundo

No passado, as abordagens para modelos de mundo foram avaliadas indiretamente. Na aprendizagem por reforço, por exemplo, os agentes são medidos pela recompensa que obtêm. Um agente pode aprender que um determinado bico do fogão "funciona melhor" porque gera mais recompensa, mas isso não implica que ele realmente aprendeu o porquê. Ele pode funcionar sem ter um modelo de mundo no sentido forte.

Em outras abordagens, como o Desafio ARC, a avaliação se concentra em saber se um sistema pode inferir regras ocultas a partir de exemplos. Por exemplo, se a regra consiste em uma relação geométrica estática em que certas figuras estão contidas dentro de outras e essa relação é preservada em novos casos, o sistema se adapta. No entanto, ele falha se a figura mudar de tamanho. Ele opera em ambientes estáticos, sem exploração ou interação.

O Framework WorldTest

O artigo Avaliação do Aprendizado de Modelo de Mundo parte dessa limitação e aponta que não é suficiente medir se um sistema prevê bem ou resolve uma tarefa. Se queremos saber se ele aprendeu um modelo de mundo, precisamos perguntar diretamente.

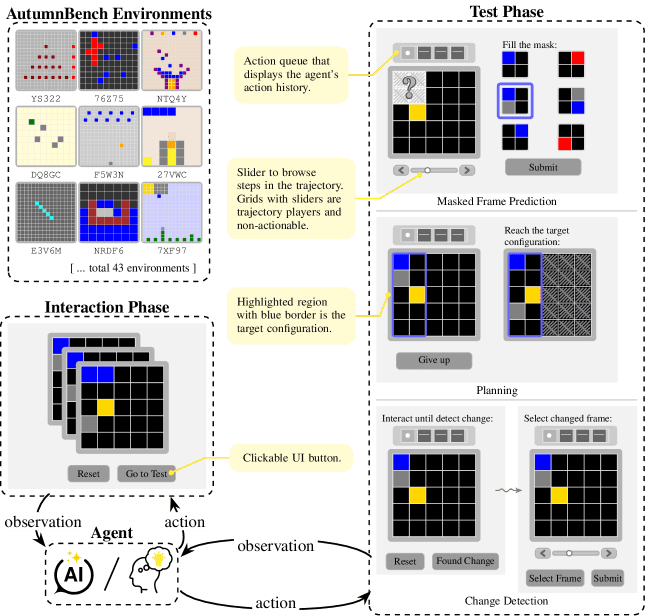

Os autores propõem um novo framework, WorldTest. A ideia é simples. Primeiro, o agente interage livremente com um ambiente sem receber recompensas externas. Em seguida, ele é confrontado com um novo desafio derivado do ambiente original, com um objetivo explícito que é diferente, mas relacionado. O desempenho neste segundo ambiente revela o que o agente realmente aprendeu sobre o mundo, não apenas quais ações maximizaram uma recompensa anterior.

Para isso, eles apresentam um conjunto de ambientes de mundo em grade com três tipos de desafios que refletem capacidades humanas muito básicas.

Figura 1: Visão geral do framework WorldTest e da instância AutumnBench. Os agentes primeiro interagem com um ambiente sem recompensas externas para construir um modelo de mundo, depois são avaliados em um desafio derivado. A caixa superior esquerda mostra os 9 exemplos de ambientes AutumnBench. Notas amarelas no meio explicam os principais elementos da interface do usuário da AutumnBench.

Exemplos do framework World Test. De Warrier et al. 2025.

O primeiro consiste em prever partes não observadas de uma trajetória final, como quando inferimos quanto tempo resta para um prato terminar de cozinhar sem vê-lo, ou quando, enquanto caminhamos por uma cidade, sabemos quão longe estamos de uma praça familiar com base na distância percorrida e pistas ambientais parciais.

O segundo requer detectar mudanças na dinâmica do ambiente e identificar quando algo para de se comportar como esperado, semelhante a perceber que uma nova cozinha funciona de forma diferente, ou notar que uma rua familiar mudou devido a construções ou fechamentos de tráfego, reconhecendo assim o momento preciso em que o ambiente não corresponde mais ao modelo anterior.

O terceiro avalia o planejamento: como a informação aprendida é usada para alcançar um objetivo, como organizar uma receita passo a passo, ou escolher e ajustar uma rota enquanto se desloca pela cidade. As decisões são tomadas com base em um estado interno que é atualizado a cada desvio, cruzamento ou correção do caminho.

Por que os Modelos de IA Falham

Os resultados relatados no artigo são reveladores. Os modelos de IA falham, não porque não "razoam", mas porque não atualizam corretamente seus dados quando informações contraditórias aparecem, aplicando regras aprendidas mesmo quando os dados não se encaixam mais.

Além disso, eles não utilizam ações neutras—como redefinir um ambiente ou não fazer nada—como ferramentas experimentais. Essas falhas não estão tanto relacionadas à memória ou raciocínio, mas à metacognição: como sabemos o que sabemos, ou seja, que informação buscar, quando duvidar e quando revisar o que foi aprendido.

Sob essa perspectiva, torna-se fácil entender por que grandes modelos de linguagem, como Claude, Gemini ou Grok, falham nesses testes. Sabemos que eles são extraordinários em gerar texto coerente e respostas fluentes. Eles parecem entender. Mas seu estado interno não é tal estado. Não há variáveis que evoluam ao longo do tempo de acordo com suas próprias dinâmicas.

Retornando aos nossos exemplos, sabemos que um LLM pode explicar como uma cozinha funciona, descrever o que aconteceria se mudássemos uma panela e explicar perfeitamente um plano de ação para uma receita. Mas ele não consegue detectar que seu modelo de mundo está falhando.

WorldTest mostra que eles falham em estabilidade temporal, em generalização dinâmica e em simular uma realidade que difere dos dados.

A Abordagem da Neuraxon

Na Neuraxon, tratamos o tempo como parte do estado do sistema. Variáveis internas existem, persistem, evoluem e mudam através de dinâmicas explícitas. O sistema não "lembra" do mundo; ele o mantém ativo.

Do ponto de vista do benchmark descrito no artigo, isso possibilita algo que os LLMs não podem oferecer: adaptar a estrutura quando as regras mudam. Não se trata de mais dados, mais parâmetros ou mais computação.

Por fim, nem todo sistema que prevê bem possui um modelo de mundo. O cérebro possui. Verificamos isso todos os dias em tarefas tão simples quanto cozinhar ou nos mover por um espaço familiar. Se a inteligência artificial aspira a algo mais, deve incluir modelos de mundo e, portanto, repensar sua arquitetura, em vez de apenas escalar seu esquema existente com poder e dinheiro. Para Neuraxon–Qubic–Aigarth, a arquitetura é dinâmica e, portanto, capaz de adaptação em tempo real.

Infraestrutura Descentralizada para Modelos de Mundo

Considerando o status atual do sistema de IA de modelo de mundo, é cristalino por que a infraestrutura computacional descentralizada se torna relevante. A arquitetura Qubic, com design descentralizado e com o mecanismo uPoW, fornece um substrato computacional onde a computação é contínua, em vez de episódica. No Qubic, uma arquitetura descentralizada não é apenas uma plataforma escalável, mas um facilitador de uma classe fundamentalmente diferente de sistemas inteligentes fundamentados em tempo real, em vez de reconstruídos em conjuntos de dados fixos anteriores.

Referências:

Warrier, A., Nguyen, D., Naim, M., Jain, M., Liang, Y., Schroeder, K., & Tavares, Z. (2025). Avaliação do Aprendizado de Modelo de Mundo. preprint arXiv arXiv:2510.19788.

Leitura relacionada: Saiba mais sobre a infraestrutura de IA da Qubic e como o uPoW possibilita a computação descentralizada.